ine 5376/79

Reconhecimento de Padrões

3. Técnicas Subsimbólicas: Redes Neurais

Parte I:

3.1. Filosofia

Geral da Aplicação do Raciocínio Subsimbólico

a Padrões: Redes Neurais Aprendendo Dados, Classificadores e Agrupadores

3.2. O

Simulador SNNS - Stutgarter Neural Network Simulator

3.3. Classificadores:

Usando Aprendizado Supervisionado para Reconhecer Padrões

Parte II:

3.4. Desenvolvimento de Aplicações: Usando Aprendizado Supervisionado

Parte III:

3.5. Agrupadores:

Usando Aprendizado Não Supervisionado para Organizar Padrões

3.5.1. O

Modelo de Kohonen e Quantização de Vetores

3.5.2. Os Mapas Auto-Organizantes

de Kohonen

3.5.2.1. Mapas topográficos

em Áreas Sensoriais

Parte IV:

3.7. Explorando

Dados Agrupados em Redes

3.5.

Agrupadores:

Usando Aprendizado Não Supervisionado para Organizar Padrões

a) como uma forma de abstração dos padrões apresentados, onde associamos cada grupo "descoberto" pelo método a uma classe ou categoria eb) como um classificador auto-organizante, onde podemos utilizar a informação codificada durante o agrupamento dos padrões em categorias como mecanismo de classificação de novos padrões, apresentados em um estágio posterior.

3.5.1. O Modelo de Kohonen e Quantização de Vetores

Consideramos o artigo de Kohonen e Ritter um marco tão importante na história das redes neurais e uma explicação tão perfeita sobre o modelo, que vamos reproduzi-lo aqui na íntegra, através da sua tradução para o Português realizada por Maricy Caregnato e Emerson Fedechen, do CPGCC da UFSC. Esta tradução será entremeada de comentários nossos e de exemplos de reprodução dos experimentos de Kohonen e Ritter com o SNNS.

3.5.2. Os Mapas Auto-Organizantes de Kohonen

Biological Cybernetics,

61, 241-254, Elsevier, Amsterdam, 1989

Tradução: Maricy Caregnato e Emerson Fedechen, CPGCC, UFSC.

Resumo

Hipóteses sobre a representação interna de Elementos da lingüística e estruturas

Categorias e suas relações para representações neurais e lingüísticas

Desde que representações de categorias ocorreram em todas as linguagens, muitos recursos tem estipulado que os elementos semânticos mais profundos de uma linguagem podem ter uma representação fisiológica em um domínio neural; e se eles são independentes de uma história cultural diferente, isso conclui que tais representações devem ser herdadas geneticamente.

Na época que a predisposição genética de elementos de linguagem foi sugerida, não havia mecanismo conhecido que teria explicado as origens das abstrações em informações neurais processada outra então evolue.. Isto não foi desde que a modelagem "redes neurais" alcançasse o nível presente quando pesquisadores começaram a descobrir de propriedades abstratas de representações internas dos sinais de modelos na rede física. Lá existe pelo menos duas classes de modelos com este potencial: a rede backpropagation e a map self-organizing. O encontrado indica que as representações internas de categorias podem ser deriváveis de relações e regras mútuas de um sinal primário ou elementos de dados.

Contudo o propósito deste paper não é afirmar que todas as representações no cérebro biológico somente são adquiridas pelo aprendizado. Os princípios adaptativos discutidos abaixo podem ser considerados como frameworks teóricos, e a primeira faze do aprendizado é a forma mais simples. É totalmente possível que um processo similar esteja trabalhando em um ciclo genético, por outro lado esses mecanismos explícitos são difíceis para imaginar.

Isso agora será próprio para abordar o problema de mapas semânticos auto organizáveis usando dados que contém informações implícitas relatando simples categorias; se mais tarde forem detectados automaticamente , podemos pensar que o passo significante em direção ao processamento lingüístico auto organizável foi feito.

Um aspecto pode ser ainda enfatizado. Isso talvez não seja razoável para procurar por elementos de linguagens no cérebro. A visão mais fundamental é que as funções fisiológicas são esperadas para refletir a organização categórica e não tanto as formas lingüísticas detalhadas.

Exemplos de modelos de redes neurais para representações internas

Mapas de auto organização (características topológicas)

A forma mais genuína de auto organização é o aprendizado competitivo que tem a capacidade de encontrar agrupamentos das informações primárias , eventualmente em modo de organização hierárquica. Em um sistema de características de células sensitivas o aprendizado competitivo significa que um número de células está comparando os mesmos sinais de entrada com seus parâmetros internos , e a célula com o melhor competidor (winner) é então auto ajustada a esta entrada. Desta forma diferentes células aprendem diferentes aspectos da sua entrada , que podem ser considerados como a mais simples forma de abstração.O mapa de auto organização é um adiantado desenvolvimento do aprendizado competitivo em que a célula de melhor entrada também ativa seus vizinhos topográficos na rede para fazer parte no afinamento da mesma entrada. Um acerto, não significa resultado óbvio coletivo , o aprendizado coletivo assume a rede neural como uma falha de duas dimensões. As diferentes células tornam-se ajustados a diferentes entradas em uma moda ordenada , definindo características de sistemas de coordenadas através da rede. Após o aprendizado, cada entrada obtém uma resposta localizada , qual posição no papel reflete a mais importante "coordenada característica"da entrada. Isso corresponde a uma projeção não linear do espaço de entrada na rede que faz a melhor relação de vizinhança entre elementos explícitos geometricamente. Particularmente se os dados são agrupados hierarquicamente , uma representação muito explícita está localizada na mesma estrutura gerada. Enquanto mapas auto organizáveis como foram usados para muitas aplicações para visualizar dados agrupados , muitas possibilidades intrigantes são diretamente possíveis de criar um processo de representação topográfica da semântica de relação não métrica implicando em dados lingüísticos.

As funções de processamento da informação estão localizadas no cérebro? Justificação do modelo.

No final do século IXX, a organização topográfica detalhada do cérebro, especialmente o cortex, já foi deduzível de déficits funcionais e falhas comportamentais que foram induzidas por vários tipos de defeitos causados acidentalmente, adequado para tumores, mal formações , hemorragias ou lesões causadas artificialmente . Uma técnica moderna causa lesões controláveis e reversíveis, é para estimular uma parte em particular na superfície cortical por pequenas correntes elétricas, através disso eventualmente induzem efeitos inibitórios e excitatórios, mas de qualquer forma uma função local assume um distúrbio. Se tal estímulo confinado globalmente então sistematicamente interrompe uma habilidade cognitiva específica tais como objetos, lá existe a menor indicação que o lugar correspondente é essencial para aquela tarefa. Esta técnica foi criticada freqüentemente pelo fato que carrega para todos os estudos nas lesões. Por outro lado uma lesão similar no mesmo lugar sempre causaria a mesma deficiência, e a mesma deficiência nunca foi produzida por um outro tipo de lesão, ela não é logicamente possível usar como dado como uma prova conclusiva para localização; a parte principal da função pode residir em outro lugar, enquanto a lesão pode destruir somente uma conexão do controle vital para ela. Hughlings Jackson já declarou "Para localizar os danos que destroem a fala e para localizar a fala são duas coisas diferentes "

Uma outra forma controlável para a determinação da localização é comprimir quimicamente ou herdar o processo que causa o engatilhamento dos neurônios , ou seja, usar pequenos retalhos embebidos em striquinina. Esta técnica foi usada com sucesso para mapear, isto é, funções sensoriais primárias.

O método mais simples é localizar uma resposta para armazenar o potencial ou encadeamento de impulsos neurais associados com ele. Apesar de desenvolver técnicas multi-eletródo geniais, este método não detectou todas as respostas em uma área desde que o encadeamento neural seja homogêneo , a união faz um neurônio particular ser mais eventual, especilamente de um sensor primário e de áreas associativas , foi feito por várias técnicas registradas eletrofisiológicamente. Evidencias mais conclusivas para localização podem ser obtidas por modernas técnicas imaginárias que mostram diretamente a distribuição espacial da ativação do cérebro associado com a função alcançando uma resolução espacial de alguns milímetros. Os dois métodos principais que são baseados em traçadores radioativos são eles: Positron Emission Tomography(PET), e auto radiografia do cérebro através de conjuntos de colimadores muito pequenos (câmara gama). PET revelam mudanças no uptake oxigênio metabolismo fosfato. O método de câmara gama detecta mudanças diretamente no fluxo sanguíneo cerebral. Os fenômenos correlate com a ativação neural local, mas eles não estão hábeis a seguir rapidamente os fenômenos. Em magnetoencephalography (MEG), o baixo campo magnético causado por respostas neurais é detectado, e por computação desses recursos, as respostas neurais podem ser diretamente ser analisada com razoável rapidez , com uma resolução espacial de junção de milímetros. A principal desvantagem é que somente tais dipoles atuais são detectáveis, as que estão em paralelo na superfície do crânio, isto é, principalmente o silco do córtex que pode ser estudado com este método.

Parece existir uma técnica não ideal que sozinha seria usada para mapear todas as respostas neurais. Ela é necessária para combinar estudos anatômicos, eletrofisiológicos, imaginários e histoquímicos.

3.5.2.1. Mapas topográficos em Áreas sensoriais

Genericamente, dois tipos de mapas fisiológicos são distinguíveis no cérebro: aqueles que soa claramente ordenados, e aqueles que são quase randomicamente organizados, respectivamente. Mapas que formam uma imagems contínuas ordenada de algumas "superfícies receptivas" podem ser encontradas na visão, e córtices somatosensoriais no cerebelo , e em certo núcleo. A escala local no fator de sublimação desses mapas depende da importância comportamental de sinais particulares , ou seja, imagens de parte foveal da retina , a ponta dos dedos e os lábios são sublimes em relação as outras partes. Há assim um mapeamento "quasiconformal"da "superfície" dentro do cérebro.Também há mais mapas abstratos, ordenados, contínuos em muitas outras áreas sensoriais primárias , tais como o tonotopic ou mapas de freqüência auditiva. Isso é uma característica comum de tais mapas que são confinados para uma área menor, raramente excedendo 5mm de diâmetro, como isso é justificado para usar o modelo dela no qual a rede total é assumida homogeneamente estruturada. Sobre uma área , um mapeamento espacialmente ordenado ao longo de uma ou duas dimensões de atributos importantes de um sinal sensorial é usualmente discernível.

Fisiologistas também usam a palavra "mapa" para respostas não ordenadas para estímulos sensoriais contanto que estes sejam localizáveis espacialmente, até se eles forem randomicamente dispersos em cima de uma área de vários centímetros quadrados e muitos tipos diferentes de respostas forem encontrados na mesma área. Respostas visuais mais complexas encontradas em níveis mais altos são mapeadas desta forma: por instância, células foram detectadas respondendo seletivamente a faces.

Evidências para localização de função lingüística :

Foi conhecido no início do século que a afasia sensorial é causada por lesão nas parte superior e posterior do lobo temporal no cérebro chamada área de Wernicke; mas com técnicas modernas de tratamento de imagem somente uma localização muito mal feita de funções da linguagem tem sido possível. Praticamente toda a função sistemática de alta resolução mapeada foi feita por um método de simulação.

É muito mais difícil localizar lingüísticas em funções semânticas no cérebro do que para mapear as áreas sensoriais primárias. Primeiro, ele ainda não esta claro para quais aspectos da linguagem as dimensões características podem corresponder. Segundo, como foi notado recentemente como um mapeamento pode ser disperso.Terceiro, resposta para elementos lingüísticos podem somente ocorrer dentro "time windows". Quarto, as técnicas experimentais usadas em animais estudados sendo usualmente evasivos, não podem ser aplicados a seres humanos, a menos que exista indicação de uma operação cirúrgica. Contudo, o significado entre evidencias experimentais já é avaliável suportando a visão do grau mais alto da localização nas funções da linguagem.

PET da imagem tem revelado que durante a tarefa de processar simples palavras , diversos lugares de cortes corticais são ativados simultaneamente. Estes não estão todos localizados na área de Wernicke :algumas partes do lobo frontal e as áreas associativas podem mostrar respostas simultaneamente também, especialmente em locais obviamente associados com percepção visual e auditiva , articulação e planejamento de tarefas.

Ao invés de estudar representações internas , localização de lugares relacionados a processos semânticos precisam de melhor resolução ao invés de um milímetro tão difícil de registrar mesmo por estímulos de mapas, entretanto este método não pode detectar algum pico de atividade temporal, isso pode apenas produzir bloqueio temporário reversível do processo em uma região confinada a um milímetro quadrado. Estimulações repetidas da mesma área causa uma espécie de deficiência temporária , isto é, erros em nomear objetos, ou dificuldade em recolecionar da memória de padrões verbais curtas. Contudo, a estimulação de algumas outra áreas apenas 5mm já separados podem induzir tipos completamente diferentes de deficiência ou sem efeito algum. Adicionalmente estes são casos de pacientes bilíngües onde nomeados pelo mesmo objeto e prejudicado em apenas uma das linguagens dependendo da área que está sendo estimilada. Isso parece como se a função da linguagem fosse organizada como um mosaico de módulos localizados .

Outra evidência indireta para um mapeamento estruturado está disponível em diversos casos nas deficiências selecionadas como resultado de pancadas ou cérebros feridos. Exemplos incluem deficiências no uso de palavras concretas por abstratas , inamimado por animado ou deixando objetos e comida contra palavras animadas. Lá existe relatório bem documentado em impairements seletivos relatando quais subcategorias como objetos internos , partes do corpo, frutas, vegetais.

Análise de qual informação tem direcionado a conclusão que existe módulos separados no cérebro por uma "palavra lexicamente visual" e a palavra lexicamente fonética para reconhecimento da palavra em semântica léxica para o significado da palavra como uma saída léxica para palavras articuladas, respectivamente cada um desses módulos pode ser independentemente falho.

As falhas categoricamente relatadas acima parecem relatar danos causado seletivamente para a "léxica semântica ". Estas observações não podem prover evidências conclusivas para a localização de classes semânticas sem a léxica, porque em todos esses casos não foi possível avaliar a extensão espacial precisamente no tecido afetado no cérebro. Nonetheles isso parece justificado para aquele estado de falha seletiva em que um grande número de casos, seria muito difícil explicar se a organização semântica aparente da observação não estivasse em alguma forma ponderada no layout espacial do sistema.

Representação de dados topologicamente relacionados em um mapa auto organizável

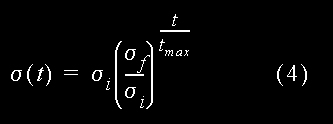

Para

a eficiência do processo e conveniência matemática,

todos os vetores de entrada são sempre normalizados para tamanho

único, considerando que o wr não precisa ser normalizado

explicitamente no processo , cedo ou tarde o processo os normalizará

automaticamente. Os neurônios estão arranjados em uma grade

bi-dimensional, e cada neurônio está rotulado pela sua grade

bi-dimensional de posição r. O grupo de neurônios excitados

é escolhido para estar centralizado no neurônio s para que

x. ws seja o máximo. Esta forma e extensão são descritas

por uma função hrs , cujo valor é a excitação

do neurônio r se o centro do grupo estiver em s. Esta função

pode ser constante para todo o r em uma "zona de vizinhança" em

torno de s e zero, como em uma simulação presente em que

são supostas para descrever o mapeamento mais natural. Neste caso

hrs será o maior em r=s e declínio para zero com distância

decrementada ||r-s||. A melhor modelagem realista escolhida para hrs é:

|

Os ajustes correspondentes para a entrada X devem ser dados por:

Mapas de auto organização semântica.

O modelo básico

do sistema para mapas simbólicos aceita cada dado do vetor x como

uma concatenação de dois (ou mais) campos, um especificando

o código simbólico, denotado por xb e o outro, o conjunto

de atributos, denotado por xa, respectivamente.

|

A

seguir, nós vamos pegar cada coluna para o campo atributo xa do

animal indicado no topo. O próprio nome do animal não pertence

a xa mas ao invés disso especifica a parte do símbolo xs

do animal. Selecionar o código do símbolo pode ser feito

de uma varidade de formas. Entretanto, nós agora queremos ter certeza

que o código dos símbolos indiquem alguma informação

sobre similaridades entre os itens. Daqui nós escolhemos para a

parte simbólica do k-th animal um vetor d-dimensional, o qual k-th

componente tem um valor fixo de a, e dos quais componentes remanescentes

são zeros. Este d é o número de itens (d = 16 em nosso

exemplo). Para esta escolha, a distância métrica entre dois

vetores xs é o mesmo, irrespectivo dos símbolos codificados.

O parâmetro a pode ser interpretado como medindo a "intensidade"

de entrada dos campos simbólicos e isso determina a realtiva influência

da parte simbólica comparada com a parte atributo. Como nós

procuramos o último que irá predominar, nós escolhemos

um valor para a = 0.2 para nossa simulação. Combinando xa

e xs de acordo com (3), cada animal foi codificado por um 29-dim vetor

de dados x = [xs, xa]t (*elevado a t*). Finalmente cada vetor de dado foi

normalizado a um único tamanho. Embora isso é apenas um significado

técnico para garantir uma boa estabilidade no processo de auto-organização,

sua contraparte biológica poderá ser intensificada a normalização

dos padrões de atividade de entrada.

|

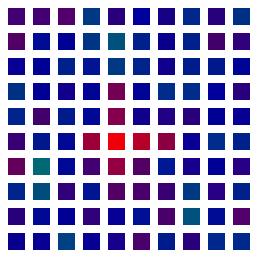

Os membros do

conjunto de dados assim obtidos foram apresentados iterativelmente e em

uma ordem randomica para uma rede planar de 10 x 10 neuronios ´sujeita

a um processo de adaptação descrito a seguir. A conecção

inicial força entre os neurônios e seus n = 29 linhas de entrada

onde são escolhidos os pequenos valores randomicos. i. e. nenhuma

ordem prioritária foi imposta. Entretanto depois de um processo

de 2000 apresentações, cada "célula" torna-se mais

ou menos responsável por uma das combinações de atributos

de ocorrência e simultâneamente para um dos nomes de animais

também. Se nóes testarmos agora qual célula dá

a resposta mais forte se apenas o nome do animal é apresentado como

dado de entrada (i.e. x =[xs,0]t (*elevado a t*), nós obtemos o

mapa mostrado na fig. 3.27 (os pontos indicam neurônios com respostas

fracas)

|

Isto é altamente aparente que a ordem espacial das respostas foi capturada a essencial "família de relacionamentos" entre os animais. Células respondendo para, e.g. "birds" ocupam a parte esquerda da rede, "hunters" como também "tiger", "lion" e "cat" recolhem para a direita, mais "peacefull" espécies como "zebra", "horse",e "cow" agregam ao meio superior. Dentro de cada conjunto, um novo agrupamento de acordo com a similaridade é discernido. A fig. 3 mostra o resultado de um "traçado simulado da penetração do eletrodo" para a mesma rede. Ela difere da fig. 2 em que agora cada célula tem sido marcada pelo símbolo que é seu melhor estímulo, i. e., extrai a melhor resposta para aquela célula. Isto faz o parcelamento do "território neural" em domínios específicos para estes itens visíveis de entrada. Hierarquia deste modo é representada por domínios aninhados. A classe geral (e.g. "bird") ocupa um largo território, no qual ele mesmo é diferenciado em subdomínios aninhados, correspondendo a mais itens especializados ("owl","duck", "hen", etc.). Embora fortemente idealizado, este resultado é muito sugestivo de como o sistema de auto-organização para guiar espacialmente a formação de traços de memória em tal maneira que seu layout físico final forma uma imagem direta da hierarquia do mais importante "conceito de relacionamentos".

O resultado da realização de uma simulação no SNNS utilizando estes dados pode ser vista na figura abaixo. Na Figura 3.30.é mostrada a ativação da rede após apresentação apenas da parte simbólica do padrão de número 13 (leão). Aqui foi utilizada uma rede de Kohonen de 10x10 com uma camada de entrada de 29 neurônios, como descrito no experimento. Observe a atividade de neurônios agrupada em um cluster em torno de um neurônio com ativação mais forte.

|

Para você repetir este experimento em casa estamos disponibilizando aqui os dados para treinamento e teste da rede descrita acima.

- Arquivo de padrões sintaxe SNNS com os dados originais

- Arquivo de padrões sintaxe SNNS com os dados com a parte de atributos atenuada

- Arquivo de padrões sintaxe SNNS para teste contendo apenas os dados da parte simbólica do vetor

- Arquivo com Planilha MS-Excel com todos os dados (para você usar com outros simuladores)

|

Para a nossa demonstração, nós usamos um conjunto de 3 sequências de palavras randomicamente geradas construídas do vocabulário da Fig. 4 a. O vocabulário contém nomes, verbos e advérbios, e cada classe contém várias subdivisões, como nome de pessoas, animais e objetos inanimados em uma categoria de nomes. Essas distinções são em parte de uma gramática, em parte da semântica natural . De qualquer forma, por razões discutidas na seção 4.1, eles mostraram não ser discerníveis de um código de palavras próprias mas apenas de um contexto de onde as palavras são usadas. Em linguagem natural, como um contexto poderia conter uma rica variedade de experiências sensoriais. Nesta demonstração muito limitada, entretanto, nós poderemos apenas pegar no cliente o contexto fornecido pelo ambiente textual imediatamente adjacente de cada palavra corrente. Isso irá retornar que mesmo este contexto extremamente restrito será suficiente para fazer saber alguma estrutura semântica interessante. É claro que isto requer que cada sentença não seja totalmente randomica, mas obedeça algumas últimas regras rudimentares de gramática e semântica com exatidão. Isto é assegurado por restringir a seleção randomica a um conjunto de 39 padrões de sentenças "legais" apenas. Cada padrão é um trio de números da figura 4b. Uma sentença é construída pela escolha de uma tripla e substituindo cada número por uma das palavras com o mesmo número na fig. 4.a. Este resultado é um total de 498 diferentes sentenças de palavras triplas, alguns dos quais são dados na fig 4c. (Se aquelas indicações são verdadeiras ou não não nos interessa: nós estamos apenas interessados exatidão semântica).

Nesta demonstração muito simples, supôs-se que o contexto de uma palavra seria suficientemente definida pelo par formado pelos seus predecessores e sucessores imediatos. (Para ter tais pares também para a primeira e última palavra da sentença, nós decidimos que as sentenças serão concatenadas em uma ordem randômica da sua produção.) Para o vocabulário de 30 palavras na fig 4a nós poderíamos ter procedido como na seção 4.1 e representado cada para por um vetor de 60-dim com dois não-zeros de entrada. Para uma codificação mais otimizada, de qualquer forma, como explicado mais detalhadamente no apêndice I, nós assumimos para cada palavra, um vetor randômico 7-dim de tamanho único, escolhido fora do conjunto para cada palavra independentemente para uma distribuição probabilística isotropica. Daqui cada par predecessor/sucessor foi representado por um codigo vetorial de 14-dim.

Isso aconteceu

em todos os nossos experimentos computacionais que preferencialmente demos

atenção para cada cláusula separadamente, uma estratégia

de aprendizagem muito mais eficiente foi considerar cada palavra neste

contexto médio sob um conjunto de cláusulas possíveis,

antes apresentando isso ao algoritmo de aprendizado. O (significado) contexto

de uma palavra foi deste modo definido primeiramente como média

sobre 10.000 sentenças de todos os códigos vetoriais de pares

predecessor/sucessor cercando essa palavra. O trigésimo resultado

da 14-dim "contexto médio de palavras", normalizada a um único

comprimento, assumiu uma regra similar como campo de atributos xa na simulação

prévia. Cada "campo de atributo" foi combinado com um 7-dim "campo

simbólico", xs consistindo em um código vetorial para a sua

palavra, mas adequada ao comprimento a. Neste momento, o uso do vetor de

código randômico quase garantiu que o campo simbólico

xs não saiba nenuma informação sobre relacionamentos

de similaridade entre as palavras. Como antes, o parâmetro a determinou

a influência relativa da parte simbólica em comparação

a parte contextual e teria o conjunto de a = 0.2.

|

Para esse experimento uma grade planar de 10 x 15 neurônios formais seriam usados. Como antes, cada neurônio inicialmente faria apenas conecções randômicas fracas ao n = 21 linhas de entrada do sistema, então novamente, nenhuma ordem inicial seria apresentada.

Depois de 2000 apresentações de entrada as respostas dos neurônios das partes simbólicas somente seriam testadas. Na fig. 5, o quadro simbólico foi escrito para mostrar o local onde o sinal do símbolo x = [xs,0]t (*elevado a T*) deu a resposta do máximo. Nós claramente vemos que os contextos tem "canalizado" os itens das palavras às posições de memória das quais refletem as relações gramáticas e semânticas. Palavras de mesmo tipo, i. e. nomes, verbos e advérbios tem segregado em separado, grandes domínios.

O "mapa semântico" obtido em uma rede de 10 x15 células depois de 2000 representações de pares de palavras-contexto derivados de 10.000 sentenças randômicas do tipo mostrado na fig. 4c. Nomes, verbos e advérbios são segregados dentro de diferentes domínios. Dentro de cada domínio um agrupamento adicional concorda com aspectos do significado como discernimento.

Cada um desses domínios é mais adiante subdividido por similaridade no nível de semântica. Por instância, nomes de pessoas e animais tendem a ser aglomerados em subdomínios em comum "domínio do substântivo", refletindo em co-ocorrências diferentes com, e.g. verbos como "correr" e "telefonar". Advérbios com significado oposto tendem a ser particularmente fechados juntos, como o oposto deles significa assegurar a eles o uso máximo do espaço comum. O agrupamento de verbos indicam diferenças nos caminhos, eles podem co-ocorrer com advérbios, pessoas, animais e objetos não animados como e.g. "comida".

Figura 6 mostra

o resultado de um outro experimento, baseado no mesmo vocabulário

e mesmo padrão de sentença como antes. De qualquer forma,

nesta simulação o contexto de uma palavra foi restrita apenas

ao seu predecessor. (O contexto agora consiste de um vetor de 7-dim). Mesmo

isto sendo muito limitado, provou como sendo suficiente para produzir um

mapa com aproximadamente similar as propriedades como na fig 5. Isto mostra

que as regularidades apresentadas são um tanto robustas para trocas

nos detalhes da codificação tão grande quanto o contexto

capturar uma quantidade suficiente da estrutura lógica subjacente.

|

Pode-se discutir que a estrutura resultante no mapa tinha sido artificialmente criada por uma escolha pre-planejada da sequência de padrões reservadas na entrada. De qualquer forma, isso é facilmente verificado nos padrões da fig. 4b quase que completamente até a exaustão das possibilidade de combinação das palavras da fig 4a em uma semanticidade bem formada de sentenças de 3 palavras (um leitor astuto pode verificar alguns "casos de linha semânticas" não cobertas, como "dog eats cat"). Isto pode tornar isso claro que todos padrões de sentenças selecionados estavam realmente determinados pelas restrições inerentes na semanticidade correta usada pelas palavras, e não vice-versa. Além disso, uma porcentagem significativa das palavras vizinhas estendem-se através das bordas das sentenças randomicamente concatenadas. Nesta concatenação foi irrestrita, tais vizinhos foram largamente irrelacionados a estrutura semântica e gramatical das sentenças, e constituíram um tipo de "ruído" no decorrer do processo. Isso é importante observar que este ruído não disfarça as regularidades se não forem apresentadas nas cláusulas.

De qualquer forma, o que importante observar está exatamente aqui. Alguma semântica realística de mapas cerebrais, precisariam de um modelo hierárquico probabilístico muito mais complicado. A finalidade de um simples modelo artificial usado neste trabalho foi apenas demostrar o potencial de um processo auto organizacional par formar mapas abstratos. Em particular, os resultados da simulação, como está, não poderia ser usado como referência para comparação topográfica direta com áreas do cérebro. Como uma comparação entre a fig. 5 e fig.6 mostram, existem muitos caminhos quase equivalentes, nos quais um conjuntos de relacionamentos de similaridades podem ser apresentados no mapa. Consequentemente os mapas gerados pelo modelo não são únicos, a menos que restrições adicionais, como e.g. condições limiares ou alguma ordem inicial grosseria for imposta. Estes podem então inicialmente "polarizar" o sistema que então converge a um outro único mapa.

3.5.2.4. Discussão: Kohonen é um Modelo Biologicamente Plausível ?

Na primeira simulação nós usamos inicialmente atributos explicitos, deste modo assumindo que algum mecanismo neural já tinha gerado-os. A filosofia subjacente do nosso trabalho é que uma tendência auto-organizadora similar poderia existir em todos os níveis de processamento; ilustrando isto, de qualquer forma, é apenas possível se os sinais tem algum significado para nós.

O termo "mapa semântico" usado neste trabalho, não é ainda referido a "compreensão mais elevada da palavra"; palavras estão apenas sendo agrupadas conforme o seu contexto local. Devido a grande correlação entre contexto local e significado da palavra, entretanto isto aproxima a ordenação semântica encontrada na linguagem natural, o qual presumidamente não pode ainda ser generalizada em cada fase aprendida. Isto é uma questão intrigante se algum estágio de processamento subsequente poderá criar um ordenamento que reflete significados de um nível mais elevado - dos quais poderá facilitar totalmente o entendimento da significado das palavras - por algum tipo de interação do basico processo de auto-organização.

Nosso modelo enfatiza a regra do arranjo espacial de neurônios, um aspecto apenas considerado em muitas poucas abordagens modeladas. Entretanto nós não gostamos de dar a impressão que nós nos opomos a visão de redes neurais como sistemas distribuídos. As interconecções massivas responsáveis pela interação lateral tão bem como os engramas relacionando para a memória associativa são certamente disseminado sobre uma grande área da rede.

Em outra mão, isto mostra-se inevitável que alguma tarefa de processamento complexo precisa algum tipo de segregação de informação em partes separadas, e localização do mais robusto e eficiente caminho para encontrar esta meta. Os mapas semânticos oferecem um mecanismo eficiente para gerar uma segregação significativa de informação simbólica uniforme em um nível razoavelmente alto de semânticas, e eles tem qualidade mais recente de ser o único baseado em aprendizado não-supervisionado. Se nós ainda necessitarmos considerar um timing relativo de sinais. (cf. von der Malsburg and Bienenstock 1986) remanescem o mais recente objetivo do estudo.

Existem outras novas razões não para negligenciar os arranjos espaciais das unidades de processamento. Por instância, a anatomia dos conjuntos de circuitos neurais restringem a realização da conectividade entre unidades. Mais a fundo, sinais cerebrais nãos e apoiam unicamente em transmissão de sinais axonais emitidos em distâncias selecionáveis, mas também emprega difusão de neurotransmissores e neuromoduladores, em todas semelhanças, estas restrições poderiam limitar a implementação de muitos mecanismos computacionais, a menos que este obstáculo esteja aliviada pela eficiente organização espacial oferecida pelos mapas.

De um ponto de vista hardware, se isto fosse esperado que a minimização dos custos de conectividade poderia fortalecer este tipo de design de rede neural. Isto poderia dar um indício porque uma organização topográfica é tão difundida no cérebro. Outros argumentos para localização são que a segregação espacial de representações fazem então mais lógica, pela redução de etapas para a sua inferência mútua, e logicamente de itens simbolicos similares, sendo espacialmente adjacentes, podem invocar um outro associativamente, como expressado nas leis clássicas de associação.

Uma outra observação pode ser necessária. Nossas simulações não poderão ser pegas como uma sugestão que cada palavra é representada por uma então chamada "célula mãe" no cérebro. Cada palavra é um pedaço complexo de informação provavelmente redundante codificada por uma população neuronal inteira (e várias vezes em separado "lexica", cf. 2.4). Tudo em um grande modelo idealizado usado em nossas simulações, isto não é um simples neurônio mas um subconjunto inteiro de células, cercar o mais responsável deles, que pega o mais adequado a palavra (cf. fig 3). Estes subconjuntos podem então ser engajados em novos processamentos, não capturado pelo modelo básico. O número de células atribuídas a cada subconjunto também depende da frequência das ocorrências das palavras. Isto é análoga ao caso que a frequência de ocorrência de estímulos determina o fator local ampliado em um mapa sensorial (Kohonen op. Cit., Ritter and Schulten 1986). Similarmente palavras frequentes poderiam recrutar células de um grande território neural e ser mais redundantemente representado. Como consequência, as mais frequentes palavras poderão ser menos suscetíveis aos danos locais. Esta complies com observações empíricas nos pacientes do curso, por meio do que as palavras familiares tem mais chances de sobreviver que as raras.

Finalmente, nós gostaríamos de apresentar um noção filosófica intrigante. Como indicado anteriormente, existem vária evidências biológicas e justificações teóricas para o funcionamento do cérebro, requisitando representação de seus dados de entrada por significativas partes processadas em localizações separadas espacialmente. A idéia sobre categorias fundamentais postuladas para a interpretação e entendimento do mundo mais obviamente levanta da formação prioritária de cada representação no próprio mundo biológico do cérebro.

Variação da Função de Vizinhança durante o Treinamento

3.6. O que aprende uma Rede de Kohonen ?

- uma Rede de Kohonen é inspirada na forma como se supõe que redes neurais naturais aprendem e

- o modelo originou-se a partir das pesquisas anteriores de Teuvo Kohonen em Análise de Componentes Principais e Quantização de Vetores.

|

O espaço vetorial V é um espaço qualquer com a dimensionalidade do número de variáveis de um padrão X desse espaço. O vetor de pesos ws do neurônio vencedor S pertencente a A representa uma aproximação da função de mapeamento f que associa pontos do espaço vetorial V a neurônios em A. D ws é o erro dessa aproximação representado no espaço vetorial V.

Com isso, vimos como ocorre o mapeamento de entre o espaço vetorial e o espaço do Mapa Auto-Organizante da rede de Kohonen.

Supondo agora, que os dados em V possuem uma distribuição d qualquer, como é gerada a função de mapeamento f de forma a refletir esta distribuição ?

3.6.1. Qualidades Matemáticas do Modelo de Kohonen

|

O que uma rede de Kohonen representa após o aprendizado pode ser considerado como uma generalização dessa idéia.

Se nós

observarmos uma distribuição de dados representando, por

exemplo, todos os pares de valores de duas variáveis x1 e x2 que

pertençam à categoria cj, poderemos ter um scatter plot

como

mostrado em (a) ou em (b) na , dependendo de como os dados se distribuem

|

Podemos representar a componente principal desta distribuição de dados através de um único ponto w0 no espaço vetorial, que representará exatamente o "centro de massa" da distribuição 2 , ou através de um vetor w1 que representa o "eixo principal" da distribuição 3 , indicando a sua tendência. Isto pode ser realizado através de várias técnicas estatíticas, entre outras pela Análise Fatorial, utilizada quando a nossa distribuição de dados representa várias classes.

O problema de uma representação deste tipo ocorre quando temos uma distribuição de dados como em (b). Numa situação como essa, o centro da distribuição é um ponto em V que não pertence à distribuição e o eixo principal da distribuição é uma descrição muito pobre e falha do real comportamento desta. É o caso de distribuições de dados com tendências não-lineares, que nós já abordamos no capítulo 1, quando falamos de Nearest Neighbour.

Para representarmos

adequadamente uma distribuição de dados como a representada

em (b) necessitamos de uma representação não-linear

da distribuição, dada por uma curva principal da distribuição,

como é mostrado na

|

O cálculo exato de uma curva principal, porém, pode ser um processo matemático extremamente custoso, envolvendo interpolação polinomial ou outra técnica.

Quando discutimos Nearest Neighbour, no capítulo 1, e algoritmos que o utilizam, como IBL, no capítulo 2, vimos que existe a possibilidade de se aproximar um mapeamento de uma distribuição deste tipo através da divisão desta área curva em pedaços discretos, representados através de um conjunto de protótipos w0i. Isto está muito bem exemplificado pela facilidade com que IBL representa o problem ada espiral exatamente implementando esta técnica. Para gerarmos um conjunto de protótipos w0i deste tipo, porém, é necessário que a distribuição seja conhecida. Isto é fácil, quando temos, de antemão, associada a cada padrão, a sua categoria. Mas como proceder quando não conhecemos a distribuição dos dados nem quais classes existem ?

É aqui

que a utilização de Redes de Kohonen se torna interessante:

Helge Ritter demonstrou que uma rede de Kohonen aprende exatamente uma

representação não linear discretizada deste tipo,

sem necessidade de que se forneça de antemão as classes a

que pertence cada padrão, realizando uma espécie de Análise

Fatorial Não-Linear Discretizada. O resultado do processo de aprendizado,

quando a convergência ocorreu adequadamente, é um mapeamento

de subconjuntos da distribuição de dados a neurônios

específicos da Rede A, que passam a fungir como protótipos

para esses subconjuntos. Regiões vizinhas da distribuição

são mapeadas para neurônios vizinhos no mapa de Kohonen A.

O mecanismo de escolha do vencedor, similar a idéia do Nearest Neighbour,

é o que garantre a não-linearidade da capacidade de representação

da rede depois de treinada, agindo como uma função limiar,

intrinsecamente não-linear, que determina as fronteiras entre cada

subárea (subvolume) da distribuição mapeada. Isto

pode ser visto na figura abaixo, onde uma classe é representada

por um agrupamento (cluster) de neruônios em torno do vencedor S.

O vencedor S representa com a maior aproximação o padrão

X apresentado à rede..

|

3.7.

Explorando

Dados Agrupados em Redes